什么是 Redis backlog

TCP backlog 参数是在使用 Redis 客户端连接到 Redis 服务器时,操作系统用于缓存的连接请求的数量。如果连接请求超出了 backlog 参数设置的值,那么新的连接请求可能会超时,这就是您所遇到的问题。

官方描述:

# TCP listen() backlog. # # In high requests-per-second environments you need an high backlog in order # to avoid slow clients connections issues. Note that the Linux kernel # will silently truncate it to the value of /proc/sys/net/core/somaxconn so # make sure to raise both the value of somaxconn and tcp_max_syn_backlog # in order to get the desired effect. tcp-backlog 511

如何增加 Redis backlog

实际上,Redis 默认的 backlog 大小已经足够应对绝大部分的情况。但是在特殊情况下,如果我们需要处理大量的并发请求或者网络延迟较大,我们可以通过修改配置文件来增加 Redis 的 backlog。

步骤一:打开 Redis 配置文件

在命令行中输入以下命令,打开 Redis 的配置文件:

vi ./redis/redis.conf

步骤二:修改 Redis 配置

找到 tcp-backlog 的配置项,默认情况下该项被注释掉了,我们需要将其取消注释,并设置一个合适的值。例如,我们将 backlog 设置为 511:

tcp-backlog 511

步骤三:重启 Redis 服务器

保存并关闭 Redis 配置文件后,我们需要重启 Redis 服务器,使配置生效。在命令行中输入以下命令:

sudo systemctl restart redis

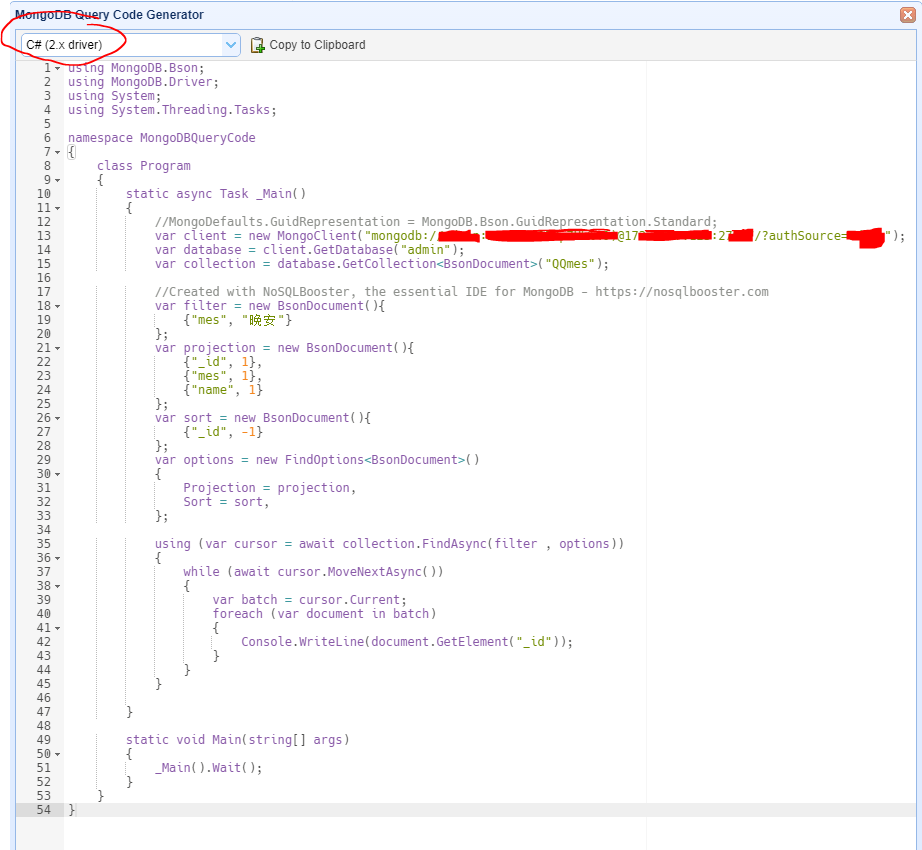

代码示例

下面是一个使用 Redis 的简单示例,演示了如何增加 Redis backlog:

import redis # 创建 Redis 连接池 pool = redis.ConnectionPool(host='localhost', port=6379, db=0, socket_connect_timeout=2, socket_timeout=2, socket_keepalive=True) # 创建 Redis 客户端 redis_client = redis.Redis(connection_pool=pool) # 增加 Redis backlog redis_client.config_set('tcp-backlog', 511) # 进行其他操作 .....

类图

下面是 Redis 客户端的类图:

结论

通过增加 Redis backlog,我们可以提高系统的并发处理能力,避免请求丢失或超时。在实际应用中,我们可以根据系统的实际情况来调整 Redis 的 backlog 大小,以达到最佳的性能表现。希望本文对你理解和使用 Redis 有所帮助。

近期评论